Pictet AM: Die Deepfake-Spürnasen

Raffinierte Deepfake-Betrügereien stellen die Cybersicherheitsbranche vor grosse Herausforderungen – eröffnen aber auch grosse Chancen.

28.05.2024 | 08:38 Uhr

2024 wird das grösste Wahljahr der Geschichte, in dem vier Milliarden Menschen zur Wahlurne schreiten werden. Fatalerweise verbreiten sich parallel zum Superwahljahr immer häufiger KI-gestützte Deepfakes, die Falschinformationen streuen könnten, um Wähler zu beeinflussen.

Deepfakes sind eine Art synthetische Medien, die das Abbild einer Person mit Hilfe einer als Deep Learning bezeichneten KI-Technik reproduzieren. Für ihre Erstellung wird ein ML-Modell (maschinelles Lernen) mit einem grossen Datenbestand von Bildern oder Videos einer Person, wie zum Beispiel einem politischen Kandidaten oder einem Firmenchef, trainiert, um ihre einzigartigen Merkmale zu lernen und zu duplizieren. Je mehr Daten verfügbar sind, desto realistischer ist die Fälschung, weshalb auch Politiker und Prominente zu den am meisten gefährdeten Personen gehören. Mit steigendem Risiko von Deepfakes steigt auch die Nachfrage nach Investitionen in moderne Cybersicherheit.

In der Slowakei wurde letztes Jahr eine gefälschte Tonaufnahme eines Wahlkandidaten veröffentlicht, in der er über Möglichkeiten der Wahlmanipulation diskutierte, und das 48 Stunden vor Öffnung der Wahllokale – in dieser kurzen Zeit konnte der Deepfake nicht entlarvt werden. Und in Bangladesch kursierte am Wahltag im Januar ein von KI erstelltes Video, in dem ein unabhängiger Kandidat seinen Rückzug von der Wahl ankündigte. Im selben Monat erhielten US-Wähler computergesteuerte Telefonanrufe, sogenannte Robocalls, die die Stimme von US-Präsident Joe Biden imitierten und sie aufforderten, nicht an den Vorwahlen des Bundesstaates teilzunehmen. Politiker in den USA haben erkannt, dass dringend investiert werden muss. Als im Jahr 2020 400 Mio. US-Dollar für die Wahlsicherheit bereitgestellt wurden, räumten viele staatliche Vertreter der Cybersicherheit in ihren Zuschussanträgen ausdrücklich Priorität ein.

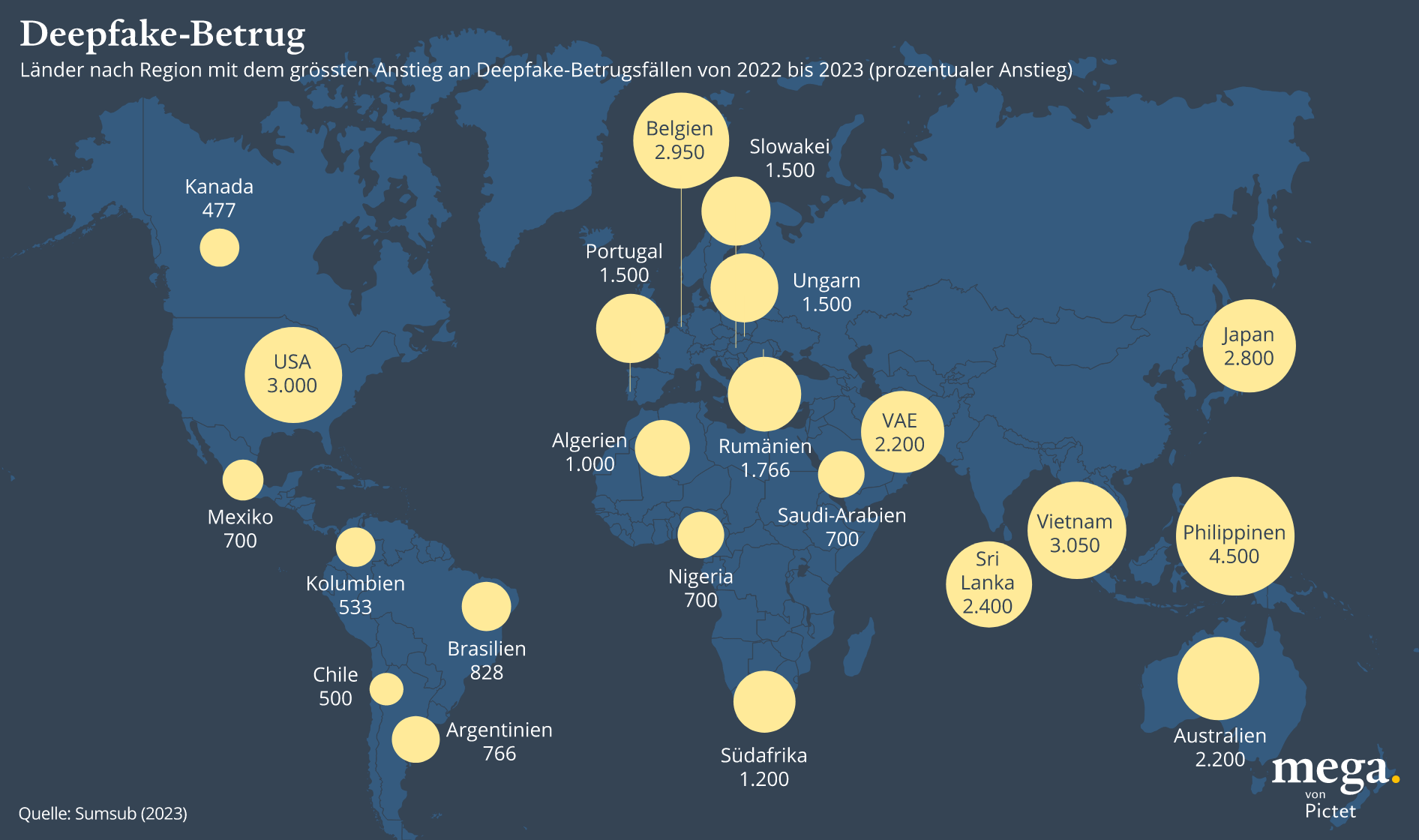

Deepfakes gibt es nicht nur in der Politik. Einer Umfrage zufolge gehen 66% der Cybersicherheitsexperten davon aus, dass im Jahr 2022 Deepfakes als Teil eines Cyberangriffs eingesetzt wurden.1 Im selben Jahr waren 26% der kleinen Unternehmen und 38% der grossen Unternehmen Ziel von KI-generiertem Identitätsbetrug.2 Ein Unternehmen verlor kürzlich 25,6 Mio. US-Dollar durch einen Betrug, bei dem ein gefälschtes Video den Finanzchef des Unternehmens zeigte, wie er von einem Mitarbeiter Geld forderte.

Insgesamt ist das Volumen gefälschter Online-Inhalte in nur einem Jahr, zwischen 2019 und 2020, um 900% gestiegen.3 Im Jahr 2026 könnte die überwiegende Mehrheit des Online-Content synthetisch generiert werden, was die Unterscheidung zwischen authentischen und betrügerischen, von KI generierten Inhalten erschweren wird.

„Die generative Funktionalität wird von Tag zu Tag besser, sodass auch die Deepfakes immer besser und realistischer werden“, sagt Ilke Demir, Forschungswissenschaftlerin bei Intel Studios. Unternehmen investieren verstärkt in Cybersicherheitstechnologien, um Bedrohungsakteuren einen Schritt voraus zu sein. Im Jahr 2022 floss durchschnittlich ein Zehntel der IT-Ausgaben in die Cybersicherheit.4 Diese Nachfrage hat nach Angaben der Unternehmensberatung McKinsey einen Markt mit einem Volumen von 2 Bio. US-Dollar für Cybersicherheitsanbieter geschaffen.

Deepfake-Abwehr

Doch Cyberkriminelle tun alles dafür, um wieder die Oberhand zu

gewinnen. „Es ist ein Katz- und Mausspiel, und im Moment werden deutlich

mehr Ressourcen in die Entwicklung neuer Formen generativer Inhalte

gesteckt als in die Entwicklung robuster Erkennungstechniken“, sagt

Henry Ajder, Consultingexperte für Deepfakes und KI.

Die

Tools zur Erkennung von Deepfakes werden ständig weiterentwickelt und an

neue Kontexte angepasst. Zum Beispiel wurden viele von ihnen

traditionell mit Daten aus westlichen Ländern trainiert. Nun hat die

Polizei in Südkorea im Vorfeld der Wahlen eine Software entwickelt, die

mit koreanischen Daten angelernt wurde. Dieses Tool gleicht mithilfe von

KI potenzielle Fakes mit bestehenden Inhalten ab, um festzustellen, ob

diese mit Deepfake-Techniken manipuliert wurden. Die Trefferquote soll

bei 80 Prozent liegen.

Viele Tools zur Erkennung von Deepfakes

basieren auf diesem Ansatz und sind darauf ausgelegt, kleine

Ungereimtheiten in Audio- und Videodateien zu erkennen, um sie als

manipuliert zu identifizieren. Eine der bisher effektivsten Techniken

verfolgt jedoch genau den entgegengesetzten Ansatz und leitet von echtem

Videomaterial einzigartige Merkmale ab, die Deepfakes nicht abbilden

können. Der „FakeCatcher“ von Intel ist ein marktführendes Tool, das

gefälschte Bilder von Menschen mithilfe der Photoplethysmographie (PPG)

identifiziert, einer Technik, die Veränderungen des Blutflusses im

Gesicht erkennt. „Wenn das Herz Blut in die Venen pumpt, ändern die

Venen ihre Farbe“, sagt Ilke Demir, die die Idee dazu hatte. „Das ist

mit blossem Auge nicht sichtbar, dafür aber maschinell.“

Die

Software sammelt PPG-Signale von allen Stellen des Gesichts und erstellt

aus den räumlichen und zeitlichen Merkmalen dieser Signale Karten.

Diese Karten werden verwendet, um ein neuronales Netz zu trainieren, das

Videos als echt oder gefälscht einstuft. Der Vorteil dieser Software

ist laut Dr. Demir, dass PPG-Signale nicht dupliziert werden können. „Es

gibt keine Möglichkeit, sie in ein generatives Modell zu integrieren

und zu versuchen, es damit zu trainieren“, sagt sie. „Deshalb ist

FakeCatcher so robust.“

FakeCatcher hat eine Trefferquote von

96 Prozent. Der britische Fernsehsender BBC testete die Technologie an

gefälschtem und an echtem Filmmaterial – mit dem Ergebnis, dass alle

Fake-Videos bis auf eins erkannt wurden. Allerdings gab es auch einige

falsche Treffer, bei denen echte Videos als Fälschungen identifiziert

wurden, weil sie unscharf waren oder die Personen von der Seite gefilmt

wurden. „Wir versuchen, so viele interpretierbare Ergebnisse wie möglich

zu liefern“, sagt Dr. Demir. „Der Nutzer des Systems sollte durch

Prüfung der verschiedenen Signale die endgültige Entscheidung treffen.“

Ajder sagt, dass jeder Ansatz zur Deepfake-Erkennung Vor- und Nachteile

hat. Er sieht vielversprechende Möglichkeiten in der Initiative der

Coalition for Content Provenance and Authenticity (C2PA), einer Art

digitaler Signatur, die von Unternehmen wie Google, Intel und Microsoft

unterstützt wird. „Es gibt Technologien, mit denen auf kryptografisch

sichere Weise Metadaten angehängt werden können, die Aufschluss darüber

geben, wie Medieninhalte erstellt und welche Tools verwendet wurden“,

sagt er. „Das ist bei weitem der beste Ansatz für die Sicherheit, aber

es ist eine Mammutaufgabe.“

Die C2PA arbeitet an einem Standard

für das Anhängen von Inhaltsurhebernachweisen. „Der Druck, solche

Technologien einzusetzen, nimmt definitiv zu“, sagt Ajder. „Wenn es

keine breite Zusammenarbeit und Abstimmung gibt, insbesondere zwischen

den grossen Unternehmen, werden wir am Ende zu viele verschiedene

Authentifizierungsprodukte und -plattformen haben, die den Nutzern das

Leben schwer machen.“

Dieser Ansatz hat zwar Vorteile, könnte

aber auch ethische Probleme hinsichtlich des Datenschutzes aufwerfen. Es

gibt Bedenken, dass der Standard zu viele Daten über die Herkunft des

Bildes preisgibt, zum Beispiel den Ort oder den Zeitpunkt der Aufnahme.

Dies könnte beispielsweise im Kontext einer Menschenrechtsorganisation

ein Risiko darstellen.

Ajder fügt hinzu, dass Technologie

allein das Deepfake-Problem niemals vollständig lösen kann und dass alle

Nutzer eine kritischere Haltung gegenüber den von ihnen konsumierten

Medien einnehmen müssen. „Wir müssen unser Verbraucherverhalten ändern

und dürfen nicht mehr alles glauben, was wir sehen. Vielmehr müssen wir

auf Inhaltsurhebernachweise achten und brauchen eine zusätzliche

Authentifizierungsebene“, sagt er. „Das ist eine grosse Sache.“

Einblicke für Investoren

Von Yves Kramer, Senior Investment Manager, Themenaktien, Pictet Asset Management

- KI und generative KI können anfällig für Cyberangriffe, Datenschutzverletzungen und schädliche Datenmanipulationen sein. Das wiederum befeuert die Nachfrage nach immer fortschrittlicheren Präventionsmassnahmen. Laut Gartner werden die Ausgaben für Cybersicherheit in diesem Jahr voraussichtlich um etwa 14% steigen. Da KI in immer mehr Bereiche vordringt, dürfte sich das Wachstum nach unserem Dafürhalten in Zukunft beschleunigen. Mangelnde Sicherheit kann das Vertrauen der Kunden in den Schutz sensibler Daten beschädigen, der Verbreitung von Ransomware Vorschub leisten und den Geschäftsbetrieb empfindlich stören.

- Zero-Trust-Lösungen dürften zum Mass aller Dinge werden. Sie überprüfen ununterbrochen die Anmeldedaten von Personen, die mit dem Unternehmen interagieren, sowohl intern als auch extern. Wir erwarten auch ein Wachstum bei Secure Access Service Edge (SASE), einer für die Cloud konzipierten Technologie, die softwaredefinierte Netzwerkfunktionen mit Netzwerksicherheit zusammenführt und durch die Überwachung der Identität und des Nutzerverhaltens kontinuierliche Richtlinienänderungen vornimmt. Da SASE auf Zero Trust aufbaut, ist dies eine Kernkomponente des Systems.

- Generative KI kann ebenfalls Teil der Lösung sein, da die Cybersicherheitsbranche Large Language Models (LLMs) so anpasst, dass Angriffe schneller erkannt und potenzielle Bedrohungen durch Schadcode, der von anderen Maschinen geschrieben wird, abgewehrt werden. Hierin sehen wir eine Chance – sowohl für die Sicherheitsbranche als auch für Investoren. Für Cybersicherheitsunternehmen, die in der Lage sind, KI in die digitale Abwehr zu integrieren, sind die Wachstumsaussichten in den kommenden Jahren positiv. Das gilt insbesondere für die Unternehmen, die vorrangig in Infrastruktur investieren, sowie für diejenigen, die spezielle Sicherheitssoftware und -anwendungen entwickeln.

Marketingdokument. Alle Formen von Kapitalanlagen sind mit Risiken

verbunden. Der Wert von Anlagen und die daraus erzielten Erträge sind

nicht garantiert und können sowohl steigen als auch fallen, so dass Sie

den ursprünglich investierten Betrag möglicherweise nicht

zurückerhalten.

Pictet Asset Management 2024. Alle Rechte vorbehalten. Bitte lesen Sie die Geschäftsbedingungen, bevor Sie die Website konsultieren.

Einige der auf dieser Website veröffentlichten Fotos wurden von Stéphane

Couturier, Magnus Arrevad, Lundi 13, Phovea, 13Photo, Magnum Photos,

Club Photo Pictet aufgenommen.

Diesen Beitrag teilen: