Pictet AM: Wettervorhersage der nächsten Generation mit maschinellem Lernen

Eine Reihe bedeutender Durchbrüche in der ML-basierten Wettervorhersage ermöglicht es der Wissenschaft, das Wetter von morgen mit grösserer Präzision vorherzusagen, auch wenn infolge der globalen Erwärmung immer häufiger unvorhergesehene Klimagefahren drohen.

27.11.2024 | 07:56 Uhr

Abendrot, Schönwetterbot – Morgenrot, schlecht Wetter droht.

Seit Jahrhunderten verlassen sich die Menschen auf Wettervorhersagen, um ihr Leben und ihre Lebensgrundlage zu schützen.

Die

moderne Technik geht heute weit über den Blick zum Himmel hinaus. Die

Meteorologen von heute nutzen Supercomputer, die riesige Datenmengen

anhand eines mathematischen Modells verarbeiten. Diese gigantischen

Rechner können mehr als 10.000 Billionen Berechnungen pro Sekunde

durchführen und täglich Hunderte Milliarden von Wetterbeobachtungen rund

um den Globus durchforsten.

Dennoch ist es immer noch kaum möglich, die Witterungsbedingungen im Voraus zu kennen. Die Atmosphäre ist ein dynamisches und chaotisches System mit vielen Unbekannten. Erschwerend kommt hinzu, dass die globale Erwärmung die Häufigkeit von Unwetterereignissen wie Hitzewellen, Überschwemmungen und Stürmen erhöht.

Schnelle und genaue Wettervorhersagen waren noch nie so wichtig wie heute, denn Unternehmen, Behörden und private Haushalte wollen Leben schützen, Kosten begrenzen und sich gegen Wettergefahren wappnen, die weltweit einen wirtschaftlichen Schaden von schätzungsweise 200 Mrd. US-Dollar pro Jahr verursachen.1

Zum

Glück machen es maschinelles Lernen (ML) und Big-Data-Modellierung

möglich, dass die Wissenschaft Veränderungen in der Atmosphäre mit

grösserer Präzision für längere Zeiträume Sicht vorhersagen kann.

Gleichzeitig machen technologische Fortschritte die Wettervorhersage zu

einem Geschäftsmodell und senken die Eintrittsbarrieren in einen

Bereich, der bislang ein unterfinanzierter öffentlicher Dienst war.

Ein grosser Durchbruch wurde im letzten Jahr durch vortrainierte ML-Modelle erzielt, die von dem chinesischen Unternehmen Huawei entwickelt wurden. Pangu-Weather ist ein hochauflösendes 3D-Programm, das mit nur einem Server schnellere und genauere Wettervorhersagen als mit herkömmlichen Methoden ermöglicht.

Ende 2023 stellte das Google-Unternehmen DeepMind das KI-basierte Wettervorhersagesystem GraphCast vor, das auf einem Desktop-Computer läuft. Und im März brachte Nvidia die digitale Earth-2-Plattform auf den Markt, um Wetter- und Klimabedingungen zu simulieren.

„Datengestützte Modelle können bei Extremereignissen mit auf physikalischen grössen basierten Modellen konkurrieren. Die Wissenschaft holt sehr schnell auf, und maschinelles Lernen kann uns helfen, schneller und mit höherer Auflösung Modelle zu erstellen“, sagt Dr. Nicolas Gruber, Professor für Umweltphysik an der ETH Zürich und Experte für Klimamodellierung.

„Derzeit werden die meisten Innovationen in diesem Bereich von privaten Unternehmen vorangetrieben. Alle grossen Technologieunternehmen haben in grossem Stil in dieses Gebiet investiert. Gleichzeitig ist der private Sektor auf riesige Mengen an offenen Daten angewiesen, die die Wissenschaft und öffentliche Einrichtungen wie die Wetterdienste gegen Gebühr zur Verfügung stellen. Ohne diese Daten wäre es nicht möglich gewesen, diese datenbasierten Modelle zu trainieren.

Black Box und schwarze Schwäne

Die moderne Wettervorhersage stützt sich auf die auf physikalischen

Grössen basierte numerische Wettervorhersage (NWP), bei der die

neuesten Wetterbeobachtungen, wie Temperatur, Niederschlag, Luftdruck,

Wind und Luftfeuchtigkeit, zusammen mit einem mathematischen

Computermodell der Atmosphäre zur Erstellung einer Vorhersage verwendet

werden.

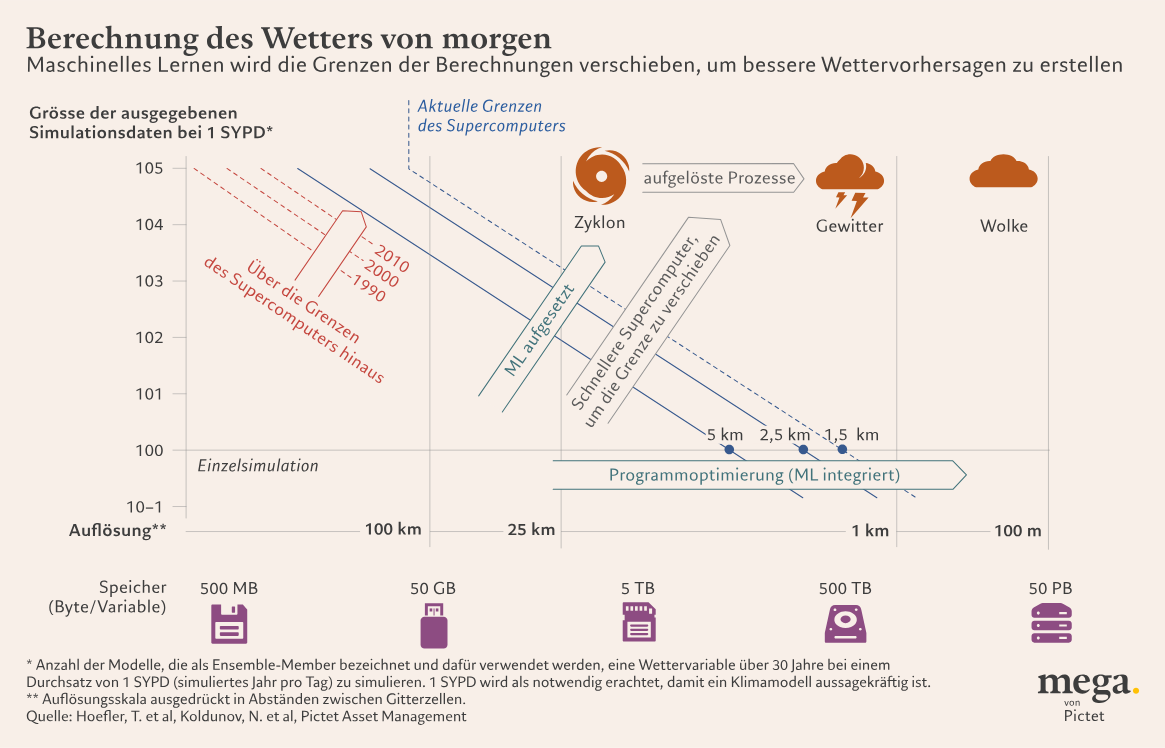

Heute, so Prof. Gruber, liegt die Gitterauflösung dank der Fortschritte im Hochleistungs-Computing bei etwa 1,5 km für einen Zeitraum von 7–10 Tagen, was doppelt so viel ist wie vor zwanzig Jahren.

Dies ist zwar ein Durchbruch, doch reicht die Auflösung noch nicht aus, um Behörden in die Lage zu versetzen, eine wirksame Katastrophenprävention und Evakuierungsplanung für Extremereignisse wie Wirbelstürme zu betreiben, und Unternehmen die Möglichkeit zu geben, Verlustrisiken für den Fall von Überschwemmungen oder Dürreperioden zu begrenzen.

„Die Herausforderung liegt in der genaueren Identifizierung der Zugbahnen und der Vorhersage der Gebiete, die evakuiert werden müssen“, sagt Prof. Gruber.

Es ist eine noch feinere Auflösung in einer Grössenordnung von einem Meter erforderlich, um genau sehen zu können, wie sich Wolken bilden und entwickeln – was für die Wissenschaftler die grösste Unsicherheitsquelle bei den Vorhersagen darstellt. Das ist bei einer herkömmlichen NWP-Methode nicht gerade günstig – Modelle mit einer Auflösung von 1 Meter benötigen 100 Milliarden Mal mehr Rechenressourcen als die heutigen fortschrittlichsten 1 km-Modelle.2

Moderne KI und ML sollen diese Herausforderungen bewältigen. Earth-2 von Nvidia erzeugt beispielsweise Bilder mit einer 12 Mal höheren Auflösung als NWP, bei 1.000 Mal höherer Geschwindigkeit und 3.000 Mal höherer Energieeffizienz.3

Prof. Gruber ist jedoch nicht ganz so zuversichtlich, dass ML-Modelle in der Lage sein werden, mit den durch den Klimawandel bedingten, noch nie dagewesenen Wetterschwankungen und -intensitäten fertig zu werden.

Typischerweise beruht maschinelles Lernen auf statistischen Regressionsmodellen, die mit Hunderten Millionen historischer meteorologischer Datenparameter wie Luftdruck oder Himmelsverhältnissen trainiert werden.

Schwerwiegende Ereignisse wie die tödlichen Überschwemmungen in Dubai im Jahr 2024 oder die Rekord-Hitzewelle in Delhi Anfang des Jahres werden dabei in der Regel nicht berücksichtigt.

„Modelle des maschinellen Lernens sind gut darin, Parameter und Datenräume zu reproduzieren, die man bereits hat. Aber man bekommt nur das, wofür man sie trainiert hat. Es wird problematisch, wenn etwas Unerwartetes passiert, das nicht Teil des Trainings ist“, so Prof. Gruber.

„Mit der globalen Erwärmung begeben wir uns auf unbekanntes Terrain – wir wissen nicht, wie die um 2 °C oder 4 °C wärmere Welt aussehen würde."

Energie- und ressourcenhungrig

ML-Modelle erfordern umfangreiches Training in einer grossen

Rechenzentrumsinfrastruktur mit Supercomputern. Prof. Gruber sagt auch,

dass der Stromverbrauch dieser Systeme die künftige Entwicklung von

Wetter- und Klimamodellierungssystemen einschränken werde.

Ein Modell, das Prof. Gruber verwendet, wird beispielsweise auf einem Supercomputer ausgeführt, der 1 Megawatt (MW) Strom benötigt. Wenn dieser Strom von einem durchschnittlichen europäischen Stromversorger geliefert wird, verursacht dies den Ausstoss von mehr als 4.000 Tonnen CO2 pro Jahr, was mehr als 25 Millionen gefahrenen Kilometern eines durchschnittlichen kraftstoffbetriebenen Autos entspricht. Einige der grössten Supercomputer der Welt verbrauchen bis zu 20 MW.

Das ist gerade jetzt sehr ungünstig, wo KI und Rechenzentren, die die Spitzentechnologie unterstützen, ohnehin schon eine Belastung für die lokalen Stromnetze darstellen. Die Internationale Energieagentur geht davon aus, dass sich der Stromverbrauch der Rechenzentren bis 2026 weltweit auf mehr als 1.000 Terawattstunden mehr als verdoppeln wird – eine Menge, die in etwa dem Jahresverbrauch Japans entspricht.

„Die Skalierung von ML-Modellen ist eine Herausforderung, da eine höhere Rechenleistung nicht immer zu einer proportionalen Leistungssteigerung führt“, sagt Prof. Gruber.

„Die Rechenleistung, die nötig ist, um mit der Weiterentwicklung der KI Schritt zu halten, verdoppelt sich etwa alle 100 Tage, was nicht nachhaltig ist. Wir müssen unbedingt ein Gleichgewicht zwischen dem Fortschreiten der KI und den Erfordernissen der Nachhaltigkeit herstellen.“

Einblicke für Investoren

Von Jennifer Boscardin-Chin, Senior Client Portfolio Manager, Themenaktien, Pictet Asset Management

- Maschinelles Lernen und künstliche Intelligenz bringen enorme Vorteile mit sich. Die Grundlage für die Spitzentechnologie bilden Rechenzentren, die mit anderen Unternehmen, Industriezweigen und Bürgern um Energie, Wasser und Land konkurrieren. Aufgrund ihres wachsenden ökologischen Fussabdrucks wird die Nachfrage nach effizienteren Lösungen zur Optimierung des Energie- und Ressourcenverbrauchs steigen.

- Immer häufiger auftretende extreme Wetterereignisse verstärken die Bemühungen, in die Anpassung an den Klimawandel zu investieren, um die Widerstandsfähigkeit von Städten und Infrastrukturen zu erhöhen. Der Markt für Klimaanpassung, einschliesslich klimafreundlicher Gebäude und Technologien, nachhaltiger landwirtschaftlicher Methoden und der Verbesserung der Katastrophenvorsorge, wird in den kommenden Jahren voraussichtlich auf einen Wert von 2 Bio. US-Dollar ansteigen (Quelle: Bank of America). Darüber hinaus ist die Kapitalrendite attraktiv: Jeder in Anpassungsstrategien investierte US-Dollar könnte bis 2030 eine Rendite von 2 bis 10 US-Dollar bringen (Quelle: World Resource Institute).

- Ob energieeffiziente Technologien oder Strategien zur Anpassung an den Klimawandel – Unternehmen, die Umweltlösungen anbieten, dürften langfristig eine nachhaltige Renditeprämie erzielen. Das liegt häufig daran, dass der Markt die Treiber des langfristigen Umweltwachstums und deren Beständigkeit unterschätzt und die kurzfristigen Gewinnschätzungen überbewertet.

1Die Schätzungen von Swiss Re basieren auf vier Wettergefahren: Überschwemmungen, tropische Wirbelstürme, Winterstürme in Europa und schwere Gewitter. https://www.swissre.com/press-release/Economic-losses-set-to-increase-due-to-climate-change-with-US-and-Philippines-the-hardest-hit-Swiss-Re-Institute-finds/3051a9b0-e379-4bcb-990f-3cc8236d55a1

2https://dl.acm.org/doi/pdf/10.1145/3592979.3593412

3https://nvidianews.nvidia.com/news/nvidia-announces-earth-climate-digital-twin

Diesen Beitrag teilen: