Inside: Orakeln in Zeiten der „Disruption“

DCF-Modelle gelten Vielen als Gold Standard. In einer zunehmend dynamischen Welt ist das Prognostizieren der Zukunft aber ein aussichtsloses Unterfangen.

29.03.2018 | 08:45 Uhr

Nicht wenige sehen in DCF-Modellen das Grundübel der modernen Finanzmarkttheorie. Hauptkritikpunkt ist, dass ein typisches Modell mit einem Zeithorizont von 5 oder 10 Jahren nun mal die größte Schwachstelle des Menschen – und aktuell auch noch der Künstlichen Intelligenz – berührt: die Vorhersage der Zukunft.

Trotz der berechtigten Kritik hat sich das DCF-Modell als das Standard-Tool zum Bewerten von Unternehmen bzw. zur Bestimmung des „Fair Value“ in der Breite durchgesetzt. Während die langsam aussterbende Gattung des Value-Investors in der Tradition von Benjamin Graham das Phantasieren über die Zukunft regelmäßig ablehnt und sich stattdessen z.B. auf Kennzahlen wie den Liquidationswert konzentriert, erfreut sich das DCF-Modell vor allem bei Growth-Investoren großer Beliebtheit.

Ein typisches DCF-Modell wird bekanntlich wie folgt aufgebaut. Eine detaillierte Modellierung der nächsten 2-3 Jahre Jahre gefolgt von begründbaren Annahmen für die weiteren Jahre. Diese begründbaren Annahmen sind gezwungener Maßen stetig – obwohl sich historisch wie empirisch eindrücklich gezeigt hat, dass Kapitalmärkte alles andere als stetig sind – und weisen bei Wachstumskennzahlen (inkl. der „terminal growth rate“) daher regelmäßig eine schleichende Rückkehr zum Mittelwert der jeweiligen Industrie auf. Währenddessen werden andere wichtige Kennzahlen wie die EBIT-Marge, Investitionsausgaben/Umsatz oder auch der Steuersatz regelmäßig ab Jahr X mehr oder weniger konstant gehalten.

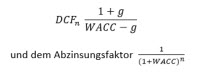

Die Schätzung des zukünftigen WACC ist dabei noch das geringste Problem. Die dominante Rolle von z.B.:

ist ohnehin eine der größten Schwachstellen eines jeden DCF-Modells.

Das skizzierte DCF-Modell mag für ein nicht-zyklisches oder auch etabliertes Geschäftsmodell mit signifikanten Wettbewerbsvorteilen und ohne absehbare regulatorische Eingriffe noch irgendwie Sinn ergeben. In Zeiten der „Disruption“, wo bestehende Industriestrukturen in kürzester Zeit aufgebrochen werden, die Halbwertzeit von Unternehmen rapide sinkt bzw. über Jahrzehnte etablierte Unternehmen in erhöhter Frequenz einfach verschwinden, stößt das Modell doch erheblich früher an seine Grenzen.

Die Realität sieht anders aus

Problematisch ist aber nicht nur die Prognosegüte für Unternehmen die möglicherweise „disrupted“ werden, sondern auch für die „Disruptors“ selbst. Unternehmen wie Amazon oder Facebook haben im historischen Vergleich in kürzester Zeit signifikante Marktmacht (Monopolrenten?) erreicht, die es ihnen offensichtlich erlaubt exorbitante Renditen auf das eingesetzte Kapital zu erzielen. Aber wie nachhaltig sind diese Margen? Wie modelliere ich möglicherweise signifikant steigende Ausgaben für den Fall einer strikteren Gesetzgebung, steigende Ausgaben für Compliance oder Rechtstreitigkeiten oder eine veränderte Steuergesetzgebung? Wie viele Analysten hatten denn signifikant höhere Ausgaben bei Facebook für „Legal & Compliance“ bereits vor einigen Wochen in ihren Modellen implementiert? Ist es wirklich ratsam, die Operative Marge von Amazon in einem Modell für die nächsten 5-10 Jahre nur infinitesimal ausschleichen zu lassen?

Analysten beantworten derartige Fragen in der Regel dadurch, dass sie ihren Modellen weitere Details hinzufügen. Durch die gesteigerte Komplexität soll die Prognosegüte verbessert werden. Vergessen werden in diesem Zusammenhang leider oftmals die „Basisraten“, die aus Erfahrungswerten hergeleitet werden und in der überwiegenden Zahl der Fälle die Wahrscheinlichkeiten für die zukünftige Entwicklung eines Unternehmens viel besser prognostizieren als noch so kleinteilige Modelle. Zu viele Details verschleiern oftmals den Blick auf das Wesentliche.

Klarer wird dies vielleicht anhand des folgenden Beispiels (frei nach Daniel Kahneman):

Laura, 25, trägt eine Brille und hat die Haare zu einem Dutt gebunden. Sie hat ein Literaturstudium abgebrochen, ist aber auch in ihrer Freizeit eine richtige Leseratte. Ist es wahrscheinlicher, dass sie

a) Bibliothekarin

b) Krankenschwester

ist?

Die richtige Antwort ist natürlich b).

So gibt es beispielsweise in Deutschland mehr als 1.000.000 Beschäftigte in Pflegeberufen, während es lediglich 40.000 Bibliothekare, Archivare und Museumfachleute gibt.

Eine zunehmend dynamische Welt braucht dynamische Modelle um sie abzubilden. Selbst dann bleibt festzuhalten: Prognosen sind schwierig, solange sie die Zukunft betreffen.

Disclaimer: Die im Blog zum Ausdruck gebrachten Einschätzungen sind die persönliche Meinung des Autors und spiegeln nicht in jedem Fall die Meinung der FondsConsult Research AG oder der €uro Advisor Services GmbH wider.

Diesen Beitrag teilen: